摘要:,,最新的模型压缩技术正在不断发展,通过优化算法和减少模型复杂度,实现了更高的性能和更低的计算成本。这些技术包括剪枝、量化、蒸馏和知识蒸馏等方法,能够有效减小模型大小,提高推理速度,并降低内存占用。随着硬件性能的不断提升和深度学习算法的持续优化,模型压缩技术将进一步发展,为人工智能的广泛应用提供更强的支持。

本文目录导读:

随着人工智能的飞速发展,深度学习模型在各种任务中取得了显著成果,大型模型通常需要巨大的计算资源和存储空间,这在很大程度上限制了其在资源受限环境中的应用,为了解决这个问题,模型压缩技术应运而生,模型压缩旨在减小模型的大小和计算复杂度,同时保持其性能,本文旨在介绍模型压缩的最新技术及其发展趋势。

模型压缩的重要性

模型压缩对于提高深度学习模型的实用性和普及性具有重要意义,模型压缩可以显著减小模型的大小,从而节省存储空间,这对于在移动设备、嵌入式设备等资源受限的环境中部署模型尤为重要,模型压缩还可以提高模型的计算效率,降低模型的计算复杂度,从而加快推理速度,这对于实时应用、在线服务和云计算等场景具有重要意义。

模型压缩的最新技术

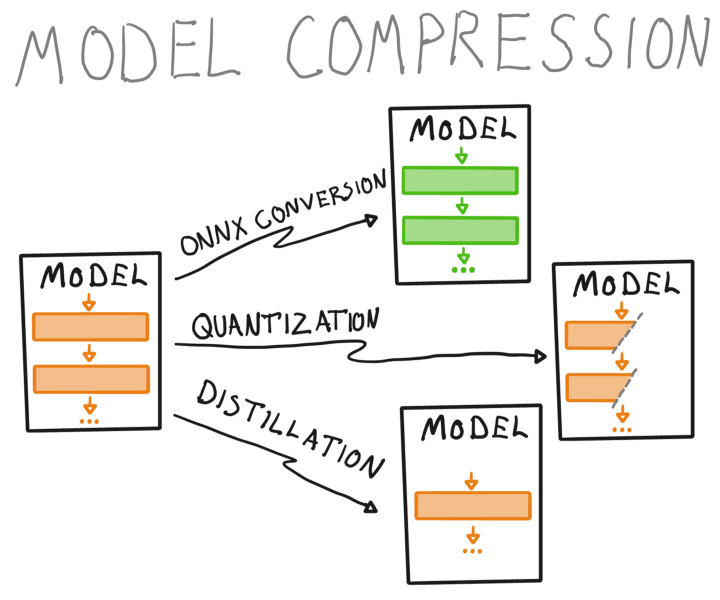

1、知识蒸馏:知识蒸馏是一种通过将一个大型模型的“知识”转移到一个较小的模型来压缩模型的方法,大型模型在训练过程中会学习到很多有用的信息,这些知识可以通过蒸馏过程转移到小型模型中,最新的知识蒸馏技术包括自蒸馏、交叉蒸馏等,可以在保持模型性能的同时实现模型压缩。

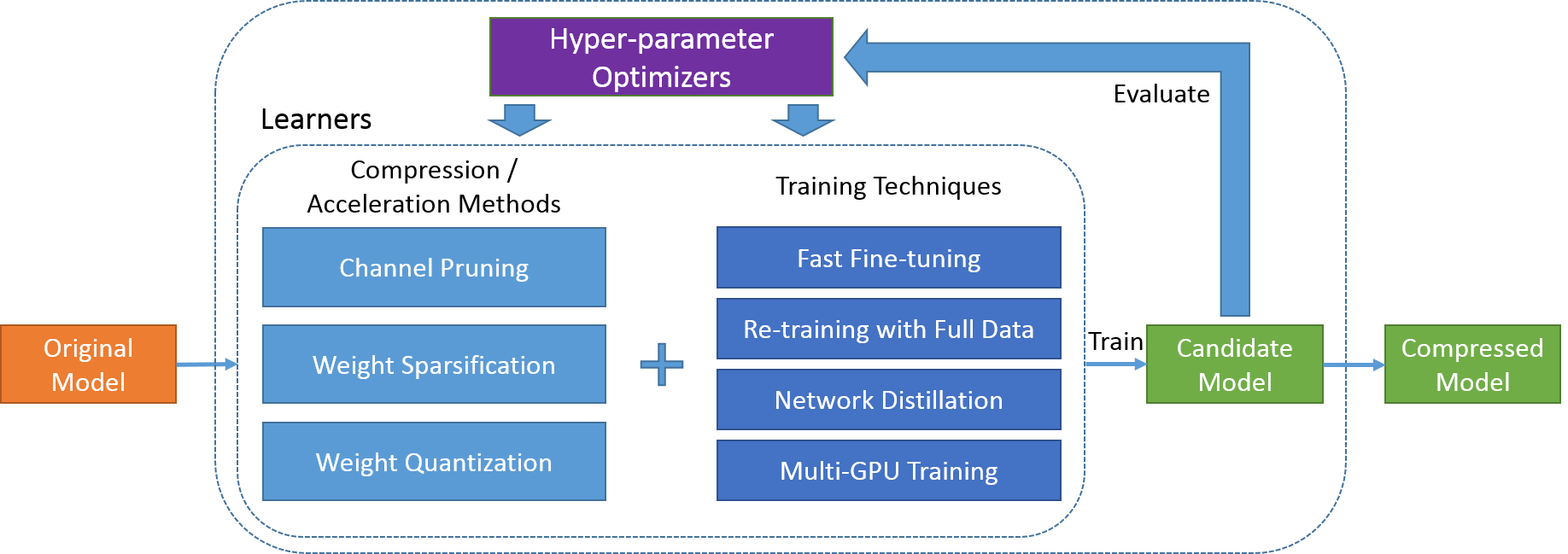

2、模型剪枝:模型剪枝是通过移除模型中的冗余参数来减小模型大小的方法,最新的模型剪枝技术包括重要性剪枝、结构化剪枝等,这些方法可以在保持模型性能的同时,显著减小模型的大小和计算复杂度。

3、量化与二进制表示:通过量化模型的权重和激活值,可以显著减小模型的大小,最新的量化技术可以实现更高的压缩率,同时保持模型的性能,二进制表示技术可以将模型的权重表示为二进制形式,进一步减小模型的大小。

4、神经网络架构搜索(NAS):NAS是一种自动化设计神经网络架构的方法,通过搜索高效的网络架构,可以在保持性能的同时实现模型压缩,最新的NAS技术已经成功应用于图像分类、语音识别等任务,并实现了显著的模型压缩效果。

发展趋势

1、跨模态模型压缩:未来的模型压缩技术将更加注重跨模态的压缩,即同时压缩图像、文本、语音等多种数据的模型,这将使得跨模态的深度学习应用更加普及,为多媒体数据处理带来更大的便利。

2、模型压缩与自适应推理的结合:随着移动设备和网络环境的普及,自适应推理的需求越来越高,未来的模型压缩技术将更加注重与自适应推理的结合,以应对不同的硬件和网络环境。

3、无损压缩与有损压缩的平衡:目前的模型压缩技术大多需要在保持性能和压缩率之间做出权衡,未来的研究方向将是如何实现无损压缩与有损压缩的平衡,以在保证模型性能的同时实现更高的压缩率。

4、模型压缩的可解释性:尽管模型压缩技术已经取得了显著的成果,但其内部机制仍然缺乏足够的可解释性,未来的研究将更加注重模型压缩的可解释性,以更好地理解模型压缩过程中的信息损失和性能变化。

模型压缩技术在提高深度学习模型的实用性和普及性方面具有重要意义,最新的技术如知识蒸馏、模型剪枝、量化与二进制表示以及神经网络架构搜索等已经在实现模型压缩方面取得了显著成果,跨模态模型压缩、与自适应推理的结合、无损与有损压缩的平衡以及模型压缩的可解释性将是主要的发展趋势,随着这些技术的发展,我们有望在未来看到更小、更快、更强大的深度学习模型。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号